一则新闻引发科技界与社会公众的广泛关注:美国民权组织ACLU的测试显示,亚马逊的人脸识别软件Rekognition将28名美国国会议员的照片错误地匹配到了警方罪犯数据库中的面孔上,且被误判的议员中,有色人种的比例显著偏高。这一事件迅速将人工智能技术,特别是人脸识别应用的伦理、准确性与公平性问题推至风口浪尖。人们不禁要问:这究竟是前沿的‘人工智能’,还是暴露了其局限性的‘人工弱智’?而作为人工智能应用软件的开发者,我们又应从这一事件中汲取哪些深刻的教训?

一、 事件剖析:技术失误还是系统偏见?

亚马逊的Rekognition软件在此次测试中的表现,绝非简单的‘程序bug’。其误判呈现出两个关键特征:

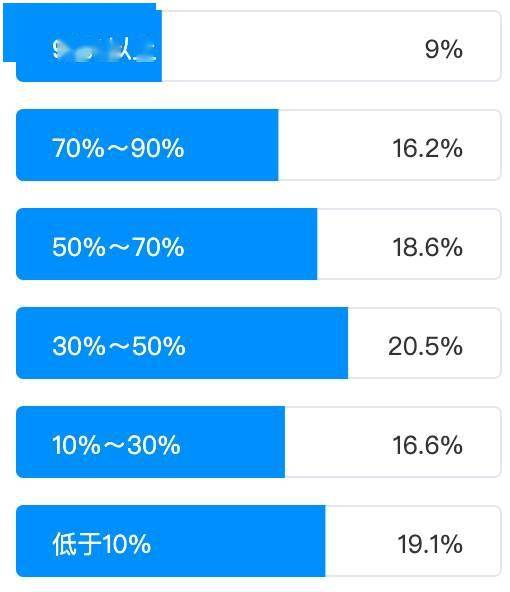

- 高错误率:在测试的535位议员中,误判28人,错误率超过5%。对于关乎人身自由与名誉的执法辅助工具而言,这一比率是难以接受的。

- 明显的种族偏差:被误判的议员中,近40%是有色人种,而美国国会中有色人种议员的比例仅为20%。这强烈暗示算法在训练数据或特征提取上可能存在系统性偏见,导致对深色皮肤人种的识别准确率显著较低。

这揭示了一个核心问题:当前许多人工智能应用,尤其是基于机器学习模型的应用,其‘智能’高度依赖于训练数据的质量、数量和代表性。如果训练数据本身包含社会既有偏见(如警方数据库的历史逮捕记录可能反映执法中的种族不平等),或某一群体(如深肤色人群)的数据样本不足,算法就会‘学习’并放大这些偏见,导致输出结果不公。这并非算法本身具有‘意识’,而是其设计、训练和部署环节中‘人’的因素出现了偏差。

二、 人工智能还是人工弱智?一个片面的二分法

将此次事件简单定性为‘人工弱智’,是对复杂技术问题的过度简化。Rekognition在商品检索、内容管理、用户验证等商业化场景中表现尚可,证明了其底层技术具备一定的‘智能’。问题在于,当技术从受控的、相对简单的商业环境,贸然进入高风险的、社会结构复杂的公共安全与司法领域时,其局限性、未经验证的可靠性和潜在的伦理风险被急剧放大。

真正的‘弱智’,或许体现在技术应用过程中的几个‘人为’环节:

- 对技术局限性的认知不足:开发者或推广者可能低估了算法在复杂现实场景(如低光照、不同角度、人口多样性)下的表现差异。

- 伦理考量的缺失:在追求算法精度和效率的未能将公平性、可解释性、问责制等伦理原则嵌入开发流程。

- 适用场景的误判:将尚未准备好应对极端后果的技术,轻率地应用于可能对公民权利产生重大影响的领域。

因此,问题不在于技术是‘智能’还是‘弱智’,而在于我们如何负责任地开发、评估和部署它。

三、 人工智能应用软件开发的深刻启示

这一争议为所有AI应用软件开发者敲响了警钟。未来的开发实践必须超越单纯的技术优化,融入更全面的责任框架:

- 数据正义先行:必须将训练数据的审计作为开发的核心环节。确保数据集的规模、多样性和质量,主动检测并修正数据中可能存在的历史与社会偏见。对于人脸识别这类技术,必须包含足够多元的种族、性别、年龄、光照条件等样本。

- 构建全面的评估体系:性能评估不能只看整体准确率,必须进行差异性分析,即针对不同人口统计学子群体(如不同种族、性别)分别评估算法的准确率、误报率和漏报率。任何在子群体间存在显著性能差异的模型,在解决此问题前都不应部署于高风险场景。

- 嵌入伦理设计:将伦理考量从事后的‘补丁’转变为事前的‘设计规范’。这包括建立多学科的伦理审查委员会,在算法中引入公平性约束,并开发使算法决策更可解释的工具,让‘黑箱’变得透明。

- 明确适用边界与人类监督:开发者有责任明确界定其技术的有效应用场景和局限性。对于高风险应用(如执法、司法、雇佣),必须坚持‘人类在环’原则,即算法结果仅能作为辅助参考,最终决策必须由经过培训、并了解技术局限的人类官员审慎做出。

- 加强行业自律与外部监管:技术公司需要建立更严格的内部测试和审计标准。这一事件也凸显了立法与监管的必要性,需要建立关于AI系统准确性、公平性测试及透明度的行业标准甚至法律法规。

###

亚马逊人脸识别软件的这次‘误判’,与其说是人工智能的‘失败’,不如说是对整个人工智能行业的一次严厉‘压力测试’。它无情地暴露了在技术狂奔背后,我们在数据、伦理、评估和责任机制上的准备不足。它提醒我们,人工智能应用软件的开发,从来不是纯粹的技术竞赛,而是一项深刻的社会技术工程。真正的‘智能’,不仅体现在算法的精妙上,更体现在开发者对技术社会影响的深刻理解、对潜在危害的主动防范、以及对公平正义的不懈追求之中。唯有将责任与伦理置于与创新同等的核心地位,我们才能确保人工智能技术真正服务于人类社会的福祉,而非反之。从‘人工弱智’的争议中学习,正是走向更负责任、更可信赖的人工智能的必经之路。